Notre but, chez PollsPosition, n'est pas de commenter frénétiquement le dernier sondage publié. C'est peut-être divertissant, mais c'est contreproductif pour faire de bonnes prévisions. Ce qui focalise notre intérêt, ce n'est pas tant les performances individuelles des instituts de sondage que leur performance globale - ce qu'on appelle "le marché". Contrairement à ce que dit la doxa populaire, ce marché a d'ailleurs bien performé ces dernières années, en ligne avec ses performances historiques.

Mais pour acquérir cette vision globale, il faut faire une analyse individuelle des sondeurs. C'est ce que fait notre classement des sondeurs , de manière systématique, méthodique et reproductible. Car l'une des pires utilisations des sondages que nous voyons revient à choisir le sondage qui confirme ce que vous pensez déjà (autrement dit, faire du "cherry-picking") :

Macron touche le fond après l'affaire #Benalla Selon YouGov, #Macron tombe à son plus bas historique en popularité. Il n'a plus que 27% (-5 points) des Francais pour le soutenir. https://t.co/DQzWxQxNkJ

— Albert Zennou (@AlbertZennou) 2 août 2018

Au moins deux choses ne vont pas dans ce tweet:

- Une baisse de 5 points sur un sondage ne veut pas dire grand chose : début août, au moment de ce tweet, sur l'ensemble des sondages, la baisse était nettement moindre (1 point). C'était -2 points en net (approuve - désapprouve). C'est mauvais, mais pas une dégringolade. Un exemple typique d'utilisation myope des sondages.

- 27% d'approbation ça peut choquer, mais quitte à utiliser les sondages un par un, autant regarder d'où ils viennent. En l’occurrence de YouGov, qui, on le voit très bien dans notre agrégateur , reporte systématiquement des résultats d'approbation nettement en-dessous de la moyenne des sondeurs. Pourquoi ? Difficile à dire; ça peut venir de leur façon de poser la question, de leur échantillon, de leur méthode de collecte, etc. Le fait est que le biais est présent et qu'il faut en tenir compte. Un exemple typique de cherry-picking.

Et ce n'est pas un journaliste lambda qui commet ces erreurs : c'est le rédacteur en chef du service politique du Figaro, et la publication en question a été retweetée près de 500 fois ! Maintenant qu'on a vu ce qu'il ne faut pas faire, penchons-nous sur ce qu'on peut vraiment dire des sondeurs français.

Des différences de performance relativement proches mais perceptibles

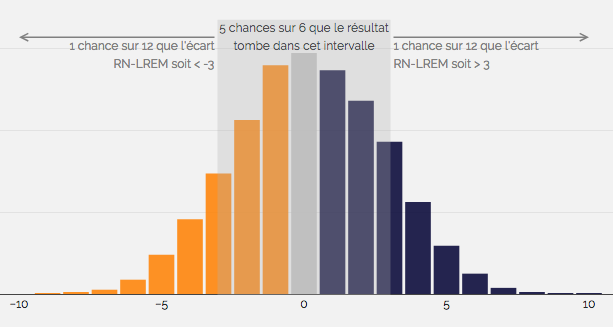

Pour évaluer la performance des sondeurs au cours du temps, nous avons mis au point un indicateur que nous appelons "erreur relative" . L'erreur relative répond à une question simple : à chaque élection, dans quelle mesure chaque institut s'est-il éloigné du marché ? Plus l'erreur relative est en-dessous de 0, plus l'institut a sur-performé le marché; plus elle est positive, plus il a sous-performé le marché. Par exemple, une erreur relative de -2 signifie que le sondeur s'est moins trompé que le marché de 2 points. Notre modèle agrège ensuite ces erreurs sur toutes les élections, en donnant plus d'influence aux présidentielles et aux élections les plus récentes (celles ayant lieu après 2006). Tous partis confondus, ça donne :

Erreur relative des sondeurs, tous partis confondus

| Institut | Erreur relative (points de %) |

|---|---|

| BVA | 0.16 |

| CSA | 0.37 |

| Elabe | -0.24 |

| Harris | -0.06 |

| Ifop | 0.26 |

| Ipsos | -0.1 |

| Kantar | 0.02 |

| Odoxa | 0.13 |

| OpinionWay | 0.25 |

Plus l'erreur relative est en-dessous de 0, plus l'institut a sur-performé le marché; plus elle est positive, plus il a sous-performé le marché. Par exemple, une erreur relative de -2 signifie que le sondeur s'est moins trompé que le marché de 2 points.

Premier enseignement, les instituts français s'éloignent relativement peu de leurs confrères - ils ne sont pas à plus de 0,5 point du marché dans les deux sens. C'est en partie rassurant : aucun n'est visiblement très mauvais. Mais aucun n'est très bon non plus. Et ce manque de variation dans les résultats, combiné au fait que les sondeurs utilisent presque tous la même méthode de collecte (des questionnaires par internet) peut traduire un comportement moutonnier ("herding") néfaste pour les prévisions : si tous les instituts se trompent dans le même sens, les modèles qui utilisent ces sondages se tromperont aussi.

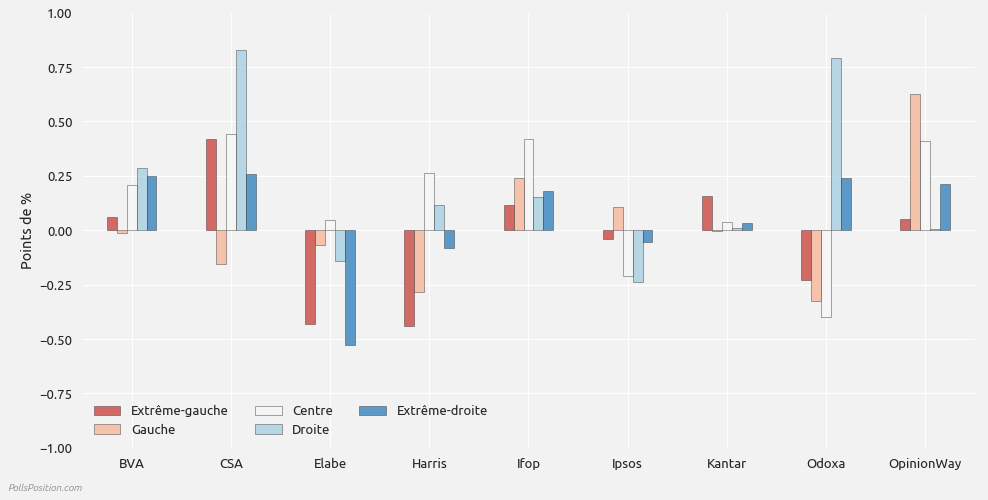

Les différences de performance sont néanmoins perceptibles, surtout quand on les analyse par parti :

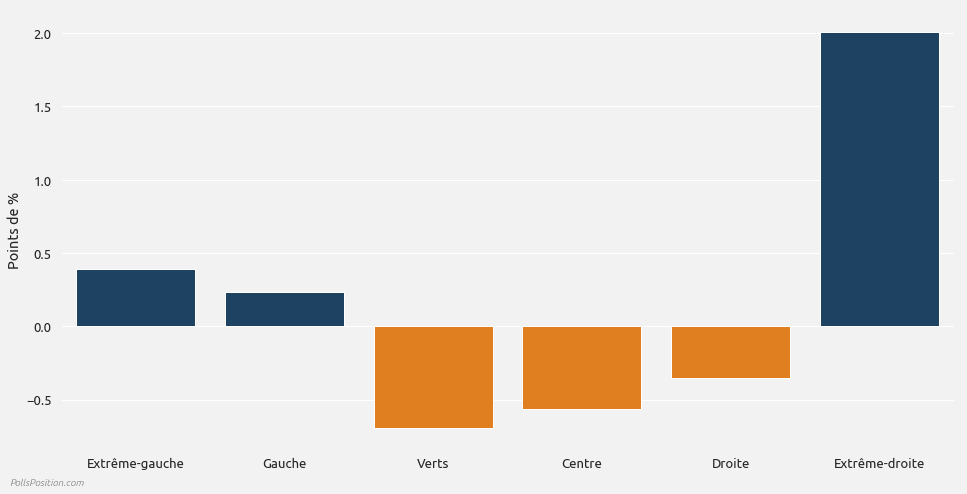

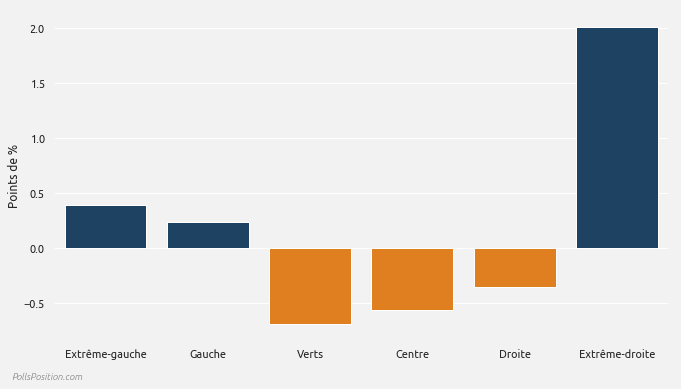

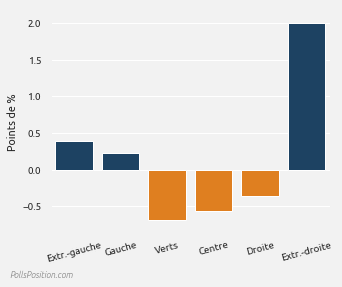

Erreurs relatives des instituts, par parti

On voit que certains instituts, comme Elabe, Odoxa ou OpinionWay, s'éloignent significativement du marché, signe qu'il y a bien des différences de performance entre instituts. D'autres en restent remarquablement proche (Kantar et Ipsos). Peut-être font-ils du herding ? Ou, au contraire, peut-être influencent-ils les autres sondeurs avec leur réputation ? Je penche pour la deuxième hypothèse : Ipsos et Kantar sont de vieux instituts, signataires de la charte de qualité de l'ESOMAR , avec un historique de bons résultats, des méthodes de collecte établies et une publication exhaustive de leurs méthodes et résultats sur chacun de leurs sondages. C'est probable que cela influence leurs confrères et que, en conséquence, ils en viennent à incarner le marché.

Enfin, la difficulté n'a pas l'air symétrique : aucun institut ne bat le marché sur tous les partis, alors que 3 d'entre eux font moins bien que le marché sur tous les partis (BVA, Ifop, OpinionWay; et même CSA). Autrement dit, c'est plus facile d'être moins bon que le marché que de le battre.

La hiérarchie est renouvelée par la régression vers la moyenne

Et même quand vous êtes en haut de la hiérarchie, rien ne garantit que vous y restez. D'un côté c'est positif : cela veut dire qu'il y a peu d'effets de rente dans la performance. Mais cela signifie aussi que c'est plus compliqué de prévoir quels instituts seront les meilleurs sur une élection donnée - d'où l'intérêt d'agréger les sondages.

On peut observer cette régression vers la moyenne en divisant le marché en 3 catégories (Meilleur, Moins bon, Ventre mou) et en calculant la proportion de temps que chaque institut passe dedans. S'il y a effectivement de la régression vers la moyenne, les proportions de chaque sondeur dans chaque catégorie devraient être assez équilibrées - du moins pas totalement déséquilibrées en faveur d'une catégorie. Et c'est effectivement ce qu'on observe :

Performance des sondeurs par rapport au marché, en % des élections qu'ils ont suivies

| Institut | Meilleur | Ventre mou | Moins bon |

|---|---|---|---|

| BVA | 0.2 | 0.3 | 0.5 |

| CSA | 0.1 | 0.2 | 0.7 |

| Elabe | 0.67 | 0.33 | 0.0 |

| Harris | 0.57 | 0.14 | 0.29 |

| Ifop | 0.17 | 0.17 | 0.67 |

| Ipsos | 0.42 | 0.17 | 0.42 |

| Kantar | 0.29 | 0.29 | 0.43 |

| Odoxa | 0.67 | 0.0 | 0.33 |

| OpinionWay | 0.25 | 0.0 | 0.75 |

Une erreur relative entre +/- 0.1 point équivaut à être dans le marché. Pour être meilleur que le marché, il faut une erreur relative < -0.1 point. Pour être moins bon que le marché, il faut une erreur relative > 0.1 point.

Au mieux donc, les instituts passent 2/3 de leur temps au-dessus du marché; pareil pour la catégorie "Moins bon". Ce qui veut dire qu'il y a une certaine hiérarchie, mais qu'elle est partiellement renouvelée à chaque élection.

Les biais des sondeurs sont faibles... sauf pour le FN

Pour expliquer les erreurs des sondeurs, de nombreuses théories sont avancées dans le débat public : les sondages sont biaisés en faveur de leur candidat favori ; les électeurs FN sont timides, donc le FN est systématiquement sous-évalué par les sondages, etc. L'avantage de ces hypothèses est qu'on peut les confronter aux données. Et - spoiler alert - elles sont fausses.

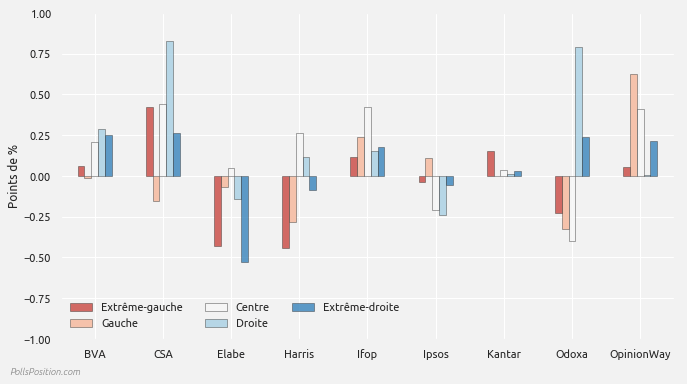

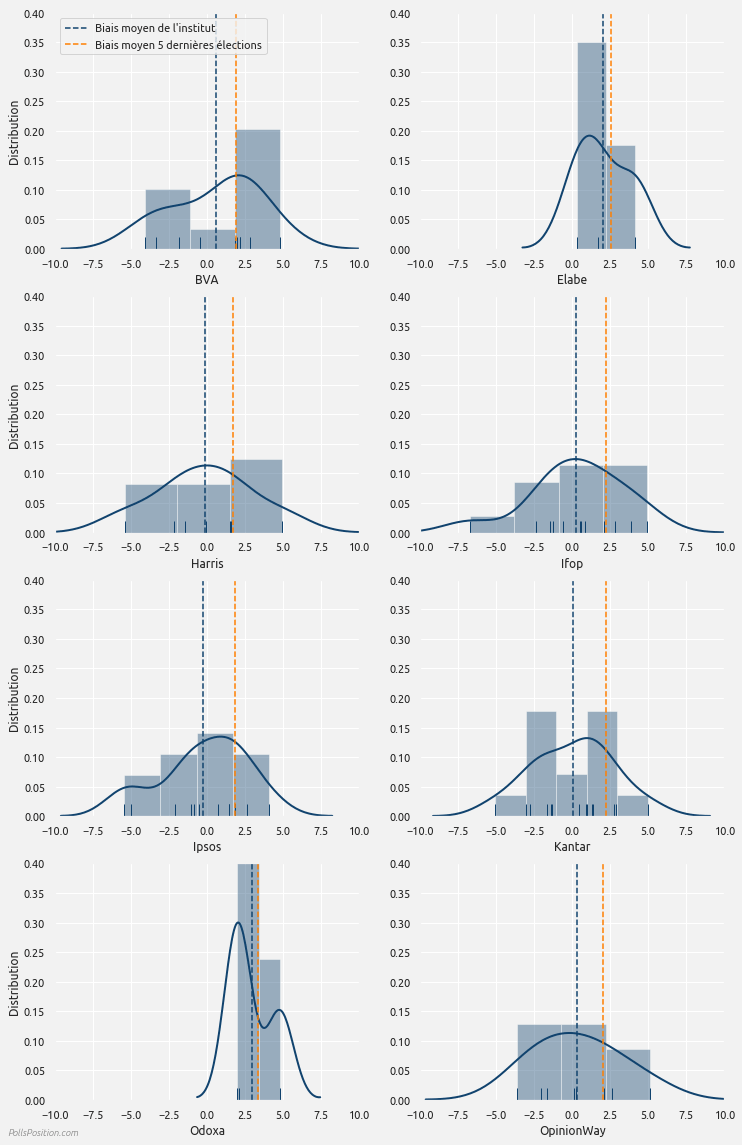

Comme le montre le graphe ci-dessous, sur les 800 sondages et 15 élections que nous avons analysés, le seul biais supérieur à 1 point concerne... le FN. Signe d'un vaste complot ? Pas vraiment, puisque l'erreur va dans le sens du FN : en moyenne, les sondeurs ont surestimé l'extrême-droite de 2 points. Autrement dit, le FN est le seul parti pour lequel les sondeurs présentent un biais important, et ce biais traduit une surestimation, ce qui va à l'encontre de la théorie des shy voters - un résultat que nous avions déjà noté .

Biais moyen pondéré de l'ensemble des sondeurs, par parti

Le biais correspond à la différence entre le sondage et le résultat de l'élection. Un biais positif indique une surévaluation du parti; un biais négatif indique une sous-évaluation du parti. La pondération est faite de façon à ce que les 5 élections les plus récentes aient le plus de poids.

Mais je vous ai caché le meilleur : ces moyennes donnent plus de poids aux 5 dernières élections dans notre base de données. Quand on les compare à une moyenne simple (qui donne autant de poids à toutes les élections, quelle que soit leur date), on s'aperçoit que la surestimation du FN est apparue récemment - ironiquement, à peu près en même temps que la thèse des shy voters.

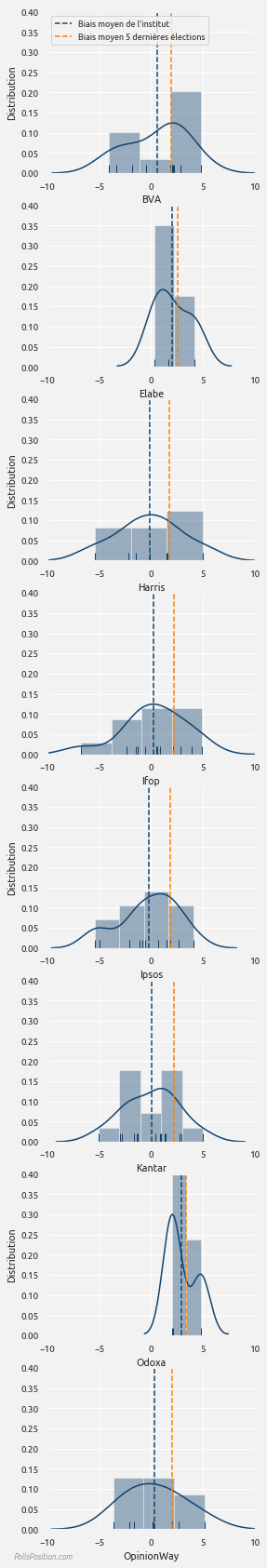

Biais moyen pondéré envers l'extrême-droite de chaque institut de sondage

Le biais correspond à la différence entre le sondage et le résultat de l'élection. Un biais positif indique une surévaluation du parti; un biais négatif indique une sous-évaluation du parti. Elabe et Odoxa n'ont participé qu'à 3 élections.

Conclusion : lors des 5 dernières élections, tous les sondeurs ont surestimé l'extrême-droite plus fortement que d'habitude. A ce niveau-là, si vous croisez un tenant du shy voting, c'est soit qu'il n'a pas regardé les données (auquel cas je vous saurais grè de lui parler de nous), soit qu'il a décidé de les ignorer. Dans un débat partisan c'est quasi-requis; pour comprendre ce que racontent les sondages c'est quasi-rédhibitoire.